一年一度的SC20国际大学生超算竞赛历来是彰显超算能力的舞台。今年尽管转战线上,各团队在为最顶级超算性能激烈角逐。来自北京的清华大学摘得桂冠,参赛团队由6名来自计算机系的本科生组成,团队搭建的计算集群系统运算性能达到了300 teraflops。*一台1 teraflop的计算机每秒可以处理一万亿次浮点运算。今年共有19支队伍参与超算竞赛。参赛者均为高中生或大学生。团队由六名成员、一名顾

目录数据并行方法一:环境变量 + device + to(device)第一步,指定*备选*的GPU直接终端中设定:python代码中设定:第二步,创建设备(device)第三步,将data和model放置到device上注意事项方法二 函数 set_device + 函数.cuda()第一步,函数set_device设置device第二部,函数.cuda()使用GPU单机多卡分布式 torch

转载

2023-06-14 18:54:53

528阅读

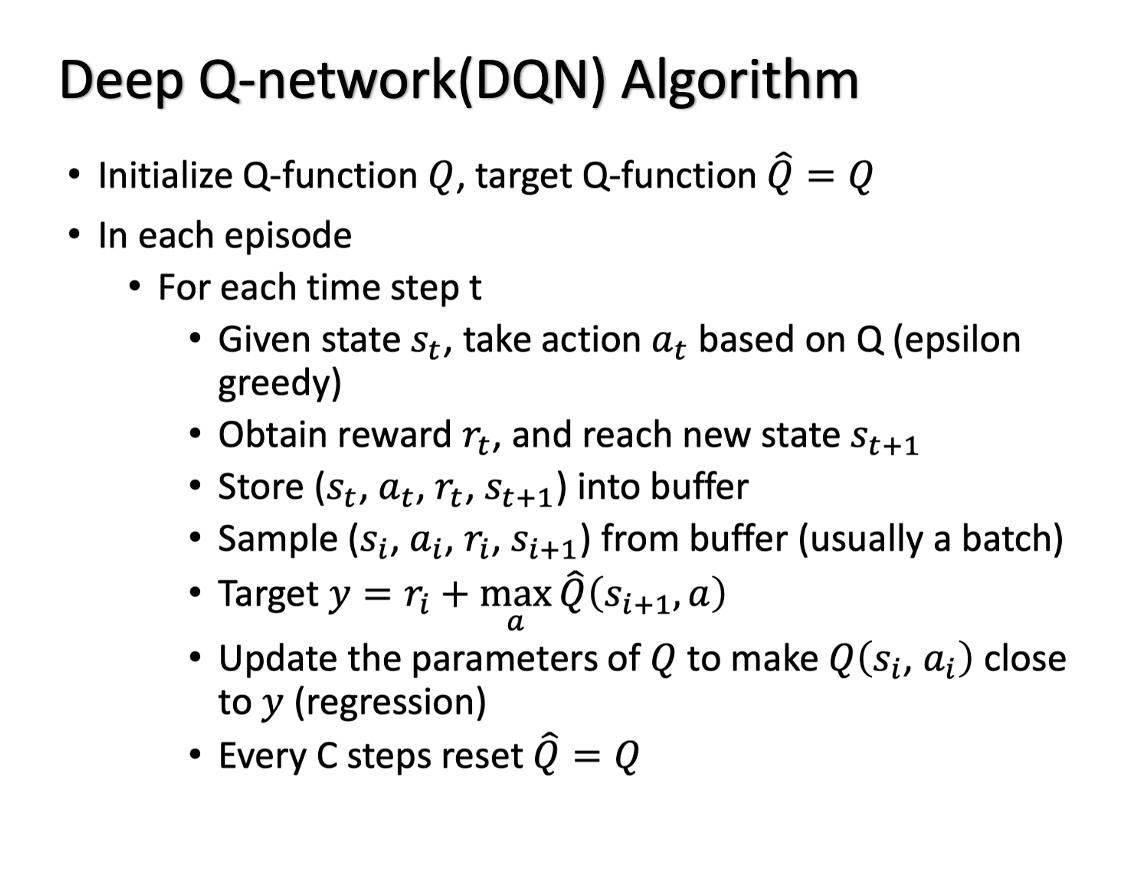

原理简介DQN是Q-leanning算法的优化和延伸,Q-leaning中使用有限的Q表存储值的信息,而DQN中则用神经网络替代Q表存储信息,这样更适用于高维的情况,相关知识基础可参考datawhale李宏毅笔记-Q学习。论文方面主要可以参考两篇,一篇就是2013年谷歌DeepMind团队的Playing Atari with Deep Reinforcement Learning,一篇是也是他们

参考:https://pytorch-cn.readthedocs.io/zh/latest/package_references/torch-autograd/#detachsource当我们再训练网络的时候可能希望保持一部分的网络参数不变,只对其中一部分的参数进行调整;或者值训练部分分支网络,并不让其梯度对主网络的梯度造成影响,这时候我们就需要使用detach()函数来切断一些分支的反向传播1

DRM - Direct Rendering Manager DRM是一个内核级的设备驱动,既可以编译到内核中也可以作为标准模块进行加载。DRM最初是在FreeBSD中出现的,后来被移植到Linux系统中,并成为Linux系统的标准部分。 DRM可以直接访问DRM clients的硬件。DRM驱动用来处理DMA,内存管理,资源锁以及安全硬件访问。为了同时支持多个3D应用,3D图形卡硬件必须作为一

转载

2024-05-08 22:44:56

38阅读

Title:Learning a Discriminative Feature Network for Semantic SegmentationFrom:CVPR2018Note data:2019/06/10 Abstract:为解决类内不一致和类内模糊两个语义分割的挑战,提出了一种判别特征网络DFN,包含了平滑网络与边界网络。 Code :pytorch目录DFN论文解读1 Abstract

转载

2024-05-27 15:43:33

23阅读

DQNDQNDQN

原创

2021-08-02 15:18:05

113阅读

一、DQN详解1) Qlearning --> DQN对于离散状态空间,若智能体所处的状态成千上万,用Qlearning表格法存储状态很不实际,对于连续状态空间同理。为了在连续状态空间下应用类似Qlearning的学习方式,需要对值函数进行逼近,故出现了DQN算法。2) DQN实现流程s : 当前状态 a : 当前s下,智能体根据策略(eval_model)给出决策a r, s_ : 当前s

转载

2024-04-18 09:35:01

893阅读

前叙:有灵魂的程序都是每一个程序员的最终目标。TensorFlow了解下? 打算花几个月学机器学习,TensorFlow是很好的选择,折腾了会环境,略有心得分享下。 环境:win10Python:3.6.5TensorFlow-GPU:1.8.0CUDA:9.0 cuDNN:7.1.4 我们来用最简单的方法安装,首先Pyt

转载

2024-08-22 07:32:56

43阅读

DQNDQNDQN

原创

2021-08-02 15:19:51

309阅读

文章目录前言强化学习与神经网络更新神经网络DQN 两大利器参考前言今天我们会来说说强化学习中的一种强大武器, Deep

转载

2022-06-27 17:08:02

102阅读

目录一、一些概念及说明二、设备信息函数一、一些概念及说明1、主机端(Host端)、设备端(Device端、GPU端)在CUDA中,有主机端和设备端这两个概念,主机端是指CPU+内存,设备端是指GPU+显存。主机端的代码在CPU上执行,访问主机内存;设备端代码在GPU上执行,访问显存。在使用GPU计算时,需要在主机内存好显存之间来回拷贝数据;当然,一些新技术可以不用拷贝数据,请参考后面的章节或者CU

转载

2024-04-05 22:29:30

533阅读

...

转载

2021-08-19 09:49:00

278阅读

2评论

DQN初步DQN初步DQN初步一 项目代码结构介绍1.1 config.py :存放所有训练需要的超参数1.2 networks.py:构建神经网络1.3 utils.py:工具类1.4 agent.py:智能代理1.5 train_ram.py:针对RAM输入进行训练

原创

2021-08-02 14:35:50

269阅读

Optimization of DQN

原创

2022-09-17 08:21:56

439阅读

# DQN PyTorch:深度强化学习的基础

*注:本文所用代码基于PyTorch 1.9和Python 3.8。*

## 引言

深度强化学习(Deep Reinforcement Learning,DRL)是结合了深度学习和强化学习的一种方法,它通过让智能体(Agent)从环境中获取数据,使用深度神经网络来学习环境的动态变化并作出相应的决策。DQN(Deep Q-Network)是一种经

原创

2023-10-13 07:22:43

126阅读

# 如何实现PyTorch中的DQN

## 一、流程概述

在实现一个基于PyTorch的深度Q网络(DQN)时,通常需要遵循以下步骤:

| 步骤编号 | 步骤详情 |

|---------|--------------------------------|

| 1 | 环境设置 |

| 2

原创

2024-10-22 04:47:39

81阅读

首先,写下这篇博客有两方面原因,一方面是为了自己复习(一个月前明明理顺代码了,现在再看又忘了),另一方面帮助和我一样的初学者快速理解DQN的代码吧。 建议边看上面博客的代码边看本文。1.代码整体整体上来说,我们需要定义三个类ReplayBuffer,Qnet,DQN。 首先从主函数部分开始看: 我们定义的num_episodes为500,通过两个for循环,将整体分为10个iteration,每个

转载

2023-08-22 19:24:51

540阅读

Tensorflow(1.x版本)核心概念Graph和Session Data Flow Graph [数据流图] 计算定义≠执行计算 计算的定义和执行,被很好地分离开了 模型跑起来,需要2步: 描绘整幅图(定义计算) 在session当中执行图中的运算Tensorflow Tensor + Flow 张量在图中通过运算(op)进行传递和变换Tensor是什么?

转载

2024-04-28 19:25:42

34阅读

window10配置paddle环境(GPU版本)开启深度学习模式~ 我安装的是CUDA9的GPU环境(CUDA10什么的同理) 检查自己电脑可以安装CUDA驱动的版本。 我的电脑的话是GF 930MX的显卡 点帮助里面的系统信息,点组件,看自己可以安装CUDA驱动的版本号。 我这里是9.1版本的,因为paddle官网上面显示不支持9.1版本的,所以我安装的是9.0版本的CUDA,可向下兼容。去

转载

2024-05-06 16:43:10

403阅读