2、tf函数TensorFlow 将图形定义转换成分布式执行的操作, 以充分利用可用的计算资源(如 CPU 或 GPU。一般你不需要显式指定使用 CPU 还是 GPU, TensorFlow 能自动检测。如果检测到 GPU, TensorFlow 会尽可能地利用找到的第一个 GPU 来执行操作.

并行计算能让代价大的算法计算加速执行,TensorFlow也在实现上对复杂操作进行了有效的改进。大部分

Tensorflow(1.x版本)核心概念Graph和Session Data Flow Graph [数据流图] 计算定义≠执行计算 计算的定义和执行,被很好地分离开了 模型跑起来,需要2步: 描绘整幅图(定义计算) 在session当中执行图中的运算Tensorflow Tensor + Flow 张量在图中通过运算(op)进行传递和变换Tensor是什么?

转载

2024-04-28 19:25:42

34阅读

...

转载

2021-08-19 09:49:00

278阅读

2评论

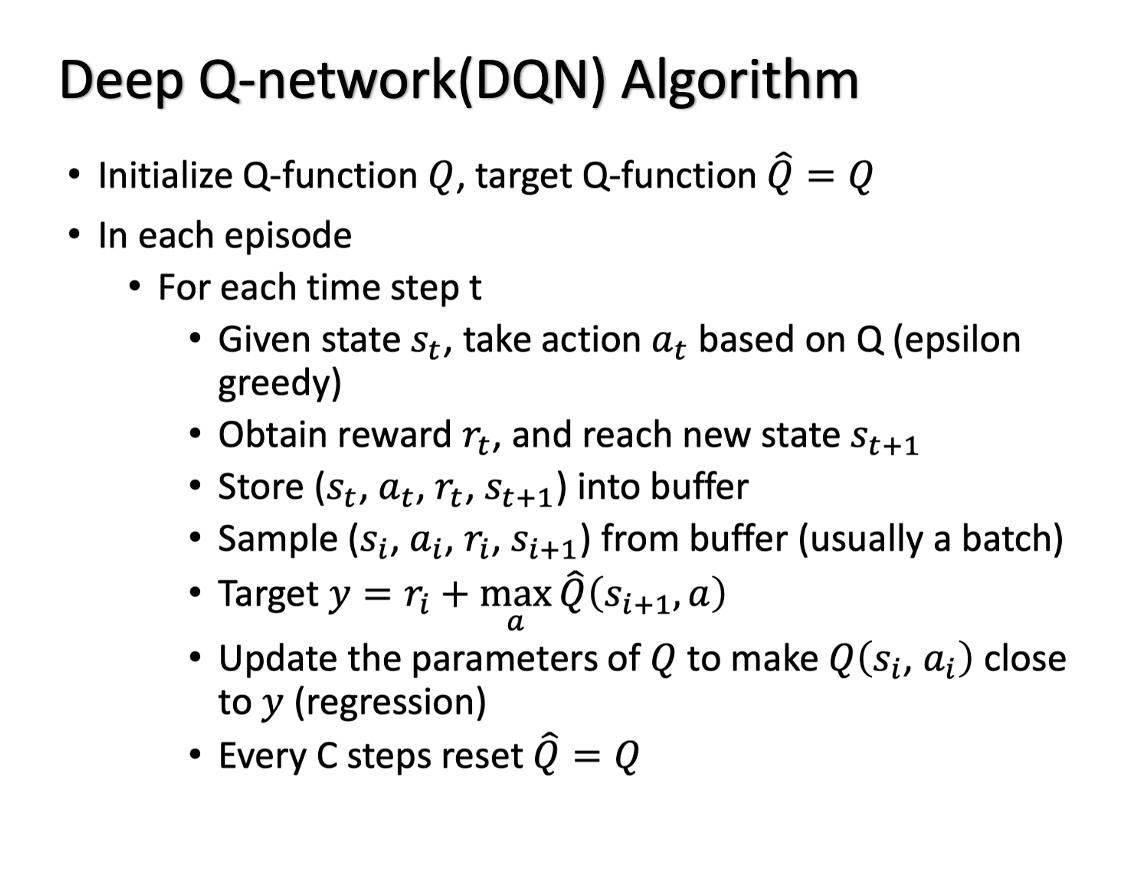

目录程序简介程序/数据集下载代码分析程序简介项目调用tensorflow.keras搭建DDQN框架的智能体,其中Q值网络为简单的CNN网络,将8皇后问题的整个表格作为输入(即环境状态),下一个皇后的摆放位置为输出(即行动),最终训练出了可独立完成8皇后问题的智能体。双深度Q网络(Double Deep Q network)DQN是一种深层神经网络的算法,用来预测Q值的大小。Q值可以理解为状态动作

转载

2024-02-20 11:22:12

23阅读

一、DQN详解1) Qlearning --> DQN对于离散状态空间,若智能体所处的状态成千上万,用Qlearning表格法存储状态很不实际,对于连续状态空间同理。为了在连续状态空间下应用类似Qlearning的学习方式,需要对值函数进行逼近,故出现了DQN算法。2) DQN实现流程s : 当前状态 a : 当前s下,智能体根据策略(eval_model)给出决策a r, s_ : 当前s

转载

2024-04-18 09:35:01

893阅读

简介PAI目前已经上线了支持多机、多卡、多PS Server的TensorFlow服务,目前只支持华北2 Region。华北2 Region因为支持多机多卡功能,适用于大规模数据的训练,相关服务需要收费,有需要的相关机构可以联系我们。原理说明Parameter Server节点:用来存储TensorFlow计算过程中的参数。配置多个PS节点,计算参数将会被自动切片并存储在不同的PS节点中,从而减小

转载

2024-10-08 10:27:08

24阅读

上篇文章强化学习——详解 DQN 算法我们介绍了 DQN 算法,但是 DQN 还存在一些问题,本篇文章介绍

原创

2023-07-13 16:48:45

2209阅读

# 使用 TensorFlow 实现 Dueling DQN:step by step 教程

Dueling DQN(Dueling Deep Q-Learning)是强化学习中的一种重要算法,能够更好地估计状态价值和动作优势。本文将引导初学者逐步实现基于 TensorFlow 的 Dueling DQN。

## 大致流程

实现 Dueling DQN 的过程可以分为以下几个步骤:

| 步

在上一篇文章强化学习——DQN介绍 中我们详细介绍了DQN 的来源,以及对于强化学习难以收敛的问题DQN算法提出的两个处理方法:经验回放和固定目标值。这篇文章我们就用代码来实现 DQN 算法一、环境介绍1、Gym 介绍本算法以及以后文章要介绍的算法都会使用 由 \(OpenAI\) 推出的\(Gym\)仿真环境, \(Gym\) 是一个研究和开发强化学习相关算法的仿真平台,了许多问题和环境(或游戏

转载

2024-03-23 10:04:48

463阅读

变量TensorFlow 是一种表示计算的方式,直到请求时才实际执行。 从这个意义上讲,它是一种延迟计算形式,它能够极大改善代码的运行:更快地计算复杂变量跨多个系统的分布式计算,包括 GPU。减少了某些计算中的冗余我们来看看实际情况。 首先,一个非常基本的 python 脚本:x = 35

y = x + 5

print(y)这个脚本基本上只是“创建一个值为35的变量x,将新变量y的值设置为它加上

转载

2024-05-27 16:54:21

28阅读

❀DQN算法原理DQN,Deep Q Network本质上还是Q learning算法,它的算法精髓还是让尽可能接近,或者说是让当前状态下预测的Q值跟基于过去经验的Q值尽可能接近。在后面的介绍中也被称为TD Target再来回顾下DQN算法和核心思想相比于Q Table形式,DQN算法用神经网络学习Q值。我们可以理解为神经网络是一种估计方法,神经网络本身不是DQN的精髓,神经网络可以设计成MLP也

深度学习基础1、化学习与深度学习的关系强化学习解决的是序列决策问题,而深度学习解决的是“打标签”问题,即给定一张图片,我们需要判断这张图片是猫还是狗,这里的猫和狗就是标签,当然也可以让算法自动打标签,这就是监督学习与无监督学习的区别。而强化学习解决的是“打分数”问题,即给定一个状态,我们需要判断这个状态是好还是坏,这里的好和坏就是分数。除了训练生成模型之外,强化学习相当于在深度学习的基础上增加了一

原创

2024-01-22 21:58:17

415阅读

在这个博文中,我们将深入探讨如何使用 Python 手写 DQN(深度 Q 网络)算法。DQN 是一种基于深度学习的强化学习算法,主要用于处理高维状态空间的决策问题,如游戏和机器人控制。

## 背景描述

近年来,强化学习作为一种智能体学习决策的有力工具,受到了广泛关注。DQN 算法的出现为这一领域带来了重大进展。尤其是在游戏 AI 的领域,DQN 已经在多个游戏中达到了超人类的表现。以下的四象

强化学习—DQN算法原理详解一、 概述强化学习算法可以分为三大类:value based, policy based 和 actor critic。常见的是以DQN为代表的value based算法,这种算法中只有一个值函数网络,没有policy网络,以及以DDPG,TRPO为代表的actor-critic算法,这种算法中既有值函数网络,又有policy网络。说到DQN中有值函数网络,这里简单介绍

转载

2024-08-11 18:47:21

68阅读

# DQN算法路径规划Python实现

## 简介

在这篇文章中,我将介绍如何使用DQN算法来实现路径规划。DQN(Deep Q-Network)是一种强化学习算法,可以在不知道环境模型的情况下学习最优策略。我们将使用Python编程语言和一些流行的机器学习库来实现这个算法。

## 整体流程

下面是我们实现DQN算法路径规划的整体流程。我们将通过表格的形式展示每个步骤。

| 步骤 | 描述

原创

2023-09-13 09:47:03

1384阅读

原理简介DQN是Q-leanning算法的优化和延伸,Q-leaning中使用有限的Q表存储值的信息,而DQN中则用神经网络替代Q表存储信息,这样更适用于高维的情况,相关知识基础可参考datawhale李宏毅笔记-Q学习。论文方面主要可以参考两篇,一篇就是2013年谷歌DeepMind团队的Playing Atari with Deep Reinforcement Learning,一篇是也是他们

动手强化学习(七):DQN 改进算法——Double DQN、Dueling DQN1. 简介2. Do

转载

2023-07-12 15:12:39

718阅读

动手强化学习(七):DQN 改进算法——Dueling DQN1. 简介2. Dueling DQN3. Dueling

转载

2023-07-12 15:12:13

229阅读

强化学习之DQN论文介绍DQN摘要介绍问题特点经验回放相关工作实验算法流程结论 DQN摘要1.基于Q-learning从高维输入学习到控制策略的卷积神经网络。2.输入是像素,输出是奖励函数。3.主要训练、学习Atari 2600游戏,在6款游戏中3款超越人类专家。介绍DQN(Deep Q-Network)是一种基于深度学习的强化学习算法,它使用深度神经网络来学习Q值函数,实现对环境中的最优行为的

转载

2023-11-27 19:47:47

275阅读

DQN算法,英文名为Deep Q Network,被称为深度Q网络,其将深度神经网络结合了Q-learning。传统的Q-learning使用表

原创

2024-02-22 11:48:33

194阅读