本教程的知识点为:机器学习算法定位、 K-近邻算法 1.4 k值的选择 1 K值选择说明 1.6 案例:鸢尾花种类预测--数据集介绍 1 案例:鸢尾花种类预测 1.8 案例:鸢尾花种类预测—流程实现 1 再识K-近邻算法API 1.11 案例2:预测facebook签到位置 1 项目描述 线性回归 2.3 数学:求导 1 常见函数的导数 线性回归 2.5 梯度下降方法介绍 1 详解梯度下降算法 线性回归 2.6 线性回归api再介绍 小结 线性回归 2.9 正则化线性模型 1 Ridge Regression (岭回归,又名 Tikhonov regularization) 逻辑回归 3.3 案例:癌症分类预测-良/恶性乳腺癌肿瘤预测 1 背景介绍 决策树算法 4.2 决策树分类原理 1 熵 决策树算法 4.3 cart剪枝 1 为什么要剪枝 决策树算法 4.4 特征工程-特征提取 1 特征提取 决策树算法 4.5 决策树算法api 4.6 案例:泰坦尼克号乘客生存预测 集成学习基础 5.1 集成学习算法简介 1 什么是集成学习 2 复习:机器学习的两个核心任务 集成学习基础 5.3 otto案例介绍 -- Otto Group Product Classification Challenge 1.背景介绍 2.数据集介绍 3.评分标准 集成学习基础 5.5 GBDT介绍 1 Decision Tree:CART回归树 1.1 回归树生成算法(复习) 聚类算法 6.1 聚类算法简介 1 认识聚类算法 聚类算法 6.5 算法优化 1 Canopy算法配合初始聚类 聚类算法 6.7 案例:探究用户对物品类别的喜好细分 1 需求 第一章知识补充:再议数据分割 1 留出法 2 交叉验证法 KFold和StratifiedKFold 3 自助法 正规方程的另一种推导方式 1.损失表示方式 2.另一种推导方式 梯度下降法算法比较和进一步优化 1 算法比较 2 梯度下降优化算法 第二章知识补充: 多项式回归 1 多项式回归的一般形式 维灾难 1 什么是维灾难 2 维数灾难与过拟合 第三章补充内容:分类中解决类别不平衡问题 1 类别不平衡数据集基本介绍 向量与矩阵的范数 1.向量的范数 2.矩阵的范数 如何理解无偏估计?无偏估计有什么用? 1.如何理解无偏估计

完整笔记资料代码:https://gitee.com/yinuo112/AI/tree/master/机器学习/嘿马机器学习(算法篇)/note.md

感兴趣的小伙伴可以自取哦~

全套教程部分目录:

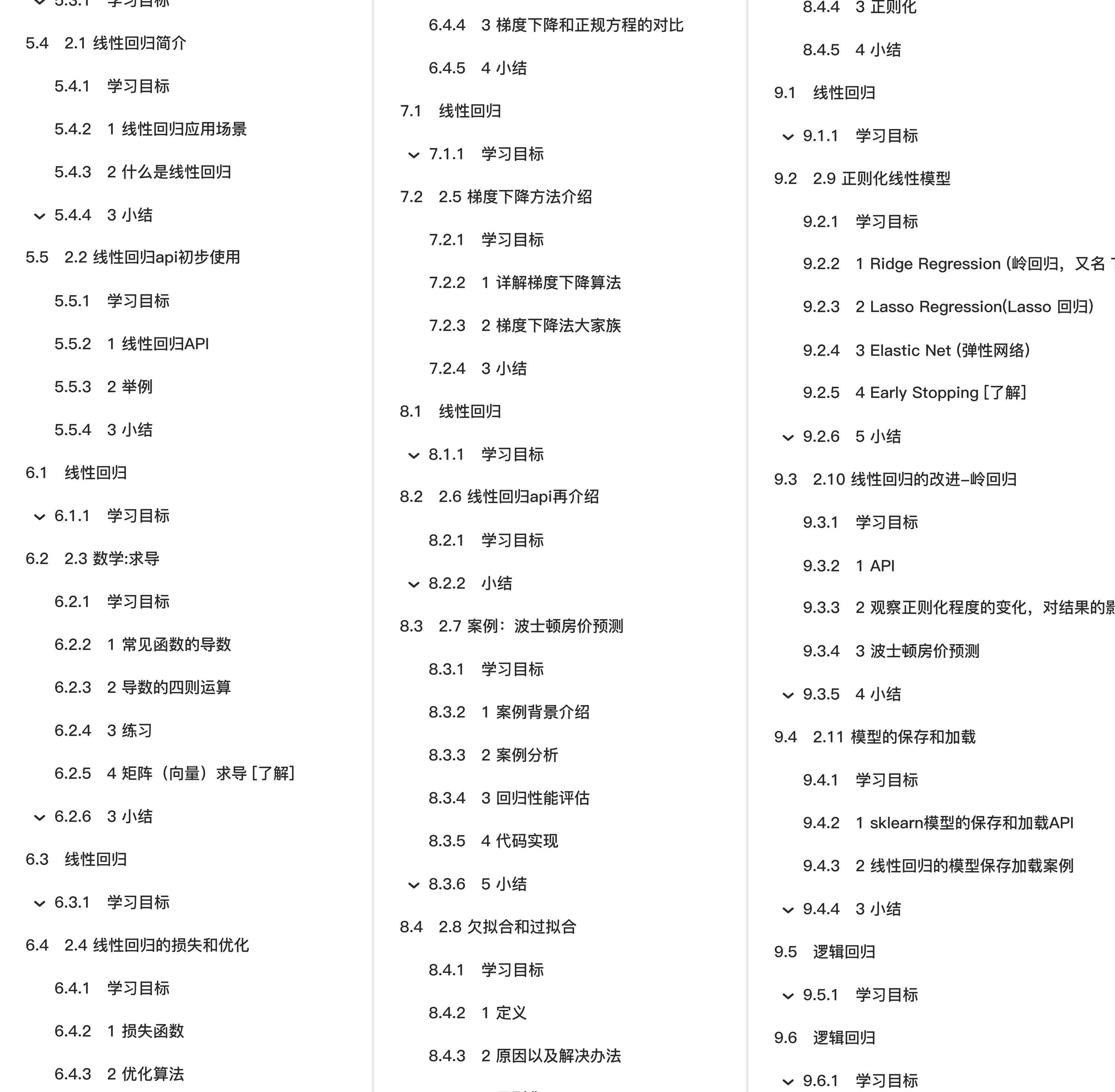

部分文件图片:

线性回归

学习目标

- 掌握线性回归的实现过程

- 应用LinearRegression或SGDRegressor实现回归预测

- 知道回归算法的评估标准及其公式

- 知道过拟合与欠拟合的原因以及解决方法

- 知道岭回归的原理及与线性回归的不同之处

- 应用Ridge实现回归预测

- 应用joblib实现模型的保存与加载

2.6 线性回归api再介绍

学习目标

- 了解正规方程的api及常用参数

- 了解梯度下降法api及常用参数

-

sklearn.linear_model.LinearRegression(fit_intercept=True)

-

通过正规方程优化

-

参数

- fit_intercept:是否计算偏置

-

属性

- LinearRegression.coef_:回归系数

- LinearRegression.intercept_:偏置

-

-

sklearn.linear_model.SGDRegressor(loss="squared_loss", fit_intercept=True, learning_rate ='invscaling', eta0=0.01)

-

SGDRegressor类实现了随机梯度下降学习,它支持不同的loss函数和正则化惩罚项来拟合线性回归模型。

-

参数:

-

loss:损失类型

- loss=”squared_loss”: 普通最小二乘法

-

fit_intercept:是否计算偏置

-

learning_rate : string, optional

-

学习率填充

-

'constant': eta = eta0

-

'optimal': eta = 1.0 / (alpha * (t + t0)) [default]

-

'invscaling': eta = eta0 / pow(t, power_t)

- power_t=0.25:存在父类当中

-

对于一个常数值的学习率来说,可以使用learning_rate=’constant’ ,并使用eta0来指定学习率。

-

-

-

属性:

- SGDRegressor.coef_:回归系数

- SGDRegressor.intercept_:偏置

-

sklearn提供给我们两种实现的API, 可以根据选择使用

小结

-

正规方程

- sklearn.linear_model.LinearRegression()

-

梯度下降法

- sklearn.linear_model.SGDRegressor()

2.7 案例:波士顿房价预测

学习目标

- 通过案例掌握正规方程和梯度下降法api的使用

1 案例背景介绍

- 数据介绍

给定的这些特征,是专家们得出的影响房价的结果属性。我们此阶段不需要自己去探究特征是否有用,只需要使用这些特征。到后面量化很多特征需要我们自己去寻找

2 案例分析

回归当中的数据大小不一致,是否会导致结果影响较大。所以需要做标准化处理。

- 数据分割与标准化处理

- 回归预测

- 线性回归的算法效果评估

3 回归性能评估

均方误差(Mean Squared Error)MSE)评价机制:

注:y<sup>i</sup>为预测值,<span class="katex"><span class="katex-mathml"><math><semantics><mrow><mover accent="true"><mrow><mi>y</mi></mrow><mo stretchy="true">‾</mo></mover></mrow><annotation encoding="application/x-tex">\overline{y}</annotation></semantics></math></span><span aria-hidden="true" class="katex-html"><span class="strut" style="height:0.63056em;"></span><span class="strut bottom" style="height:0.825em;vertical-align:-0.19444em;"></span><span class="base textstyle uncramped"><span class="mord overline"><span class="vlist"><span style="top:0em;"><span class="fontsize-ensurer reset-size5 size5"><span style="font-size:1em;"></span></span><span class="mord textstyle cramped"><span class="mord mathit" style="margin-right:0.03588em;">y</span></span></span><span style="top:-0.5505599999999999em;"><span class="fontsize-ensurer reset-size5 size5"><span style="font-size:1em;"></span></span><span class="reset-textstyle textstyle uncramped overline-line"></span></span><span class="baseline-fix"><span class="fontsize-ensurer reset-size5 size5"><span style="font-size:1em;"></span></span></span></span></span></span></span></span>为真实值

思考:MSE和最小二乘法的区别是?

-

sklearn.metrics.mean_squared_error(y_true, y_pred)

- 均方误差回归损失

- y_true:真实值

- y_pred:预测值

- return:浮点数结果

4 代码实现

4.1 正规方程

def linear_model1():

"""

线性回归:正规方程

:return:None

"""

# 1.获取数据

data = load_boston()

# 2.数据集划分

x_train, x_test, y_train, y_test = train_test_split(data.data, data.target, random_state=22)

# 3.特征工程-标准化

transfer = StandardScaler()

x_train = transfer.fit_transform(x_train)

x_test = transfer.fit_transform(x_test)

# 4.机器学习-线性回归(正规方程)

estimator = LinearRegression()

estimator.fit(x_train, y_train)

# 5.模型评估

# 5.1 获取系数等值

y_predict = estimator.predict(x_test)

print("预测值为:\n", y_predict)

print("模型中的系数为:\n", estimator.coef_)

print("模型中的偏置为:\n", estimator.intercept_)

# 5.2 评价

# 均方误差

error = mean_squared_error(y_test, y_predict)

print("误差为:\n", error)

return None

4.2 梯度下降法

def linear_model2():

"""

线性回归:梯度下降法

:return:None

"""

# 1.获取数据

data = load_boston()

# 2.数据集划分

x_train, x_test, y_train, y_test = train_test_split(data.data, data.target, random_state=22)

# 3.特征工程-标准化

transfer = StandardScaler()

x_train = transfer.fit_transform(x_train)

x_test = transfer.fit_transform(x_test)

# 4.机器学习-线性回归(特征方程)

estimator = SGDRegressor(max_iter=1000)

estimator.fit(x_train, y_train)

# 5.模型评估

# 5.1 获取系数等值

y_predict = estimator.predict(x_test)

print("预测值为:\n", y_predict)

print("模型中的系数为:\n", estimator.coef_)

print("模型中的偏置为:\n", estimator.intercept_)

# 5.2 评价

# 均方误差

error = mean_squared_error(y_test, y_predict)

print("误差为:\n", error)

return None

我们也可以尝试去修改学习率

estimator = SGDRegressor(max_iter=1000,learning_rate="constant",eta0=0.1)

此时我们可以通过调参数,找到学习率效果更好的值。

5 小结

-

正规方程和梯度下降法api在真实案例中的使用【知道】

-

线性回归性能评估【知道】

- 均方误差

2.8 欠拟合和过拟合

学习目标

- 掌握过拟合、欠拟合的概念

- 掌握过拟合、欠拟合产生的原因

- 知道什么是正则化,以及正则化的分类

1 定义

- 过拟合:一个假设在训练数据上能够获得比其他假设更好的拟合, 但是在测试数据集上却不能很好地拟合数据,此时认为这个假设出现了过拟合的现象。(模型过于复杂)

- 欠拟合:一个假设在训练数据上不能获得更好的拟合,并且在测试数据集上也不能很好地拟合数据,此时认为这个假设出现了欠拟合的现象。(模型过于简单)

那么是什么原因导致模型复杂?线性回归进行训练学习的时候变成模型会变得复杂,这里就对应前面再说的线性回归的两种关系,非线性关系的数据,也就是存在很多无用的特征或者现实中的事物特征跟目标值的关系并不是简单的线性关系。

2 原因以及解决办法

-

欠拟合原因以及解决办法

-

原因:学习到数据的特征过少

-

解决办法:

- **1)添加其他特征项,**有时候我们模型出现欠拟合的时候是因为特征项不够导致的,可以添加其他特征项来很好地解决。例如,“组合”、“泛化”、“相关性”三类特征是特征添加的重要手段,无论在什么场景,都可以照葫芦画瓢,总会得到意想不到的效果。除上面的特征之外,“上下文特征”、“平台特征”等等,都可以作为特征添加的首选项。

- 2)添加多项式特征,这个在机器学习算法里面用的很普遍,例如将线性模型通过添加二次项或者三次项使模型泛化能力更强。

-

-

过拟合原因以及解决办法

-

原因:原始特征过多,存在一些嘈杂特征, 模型过于复杂是因为模型尝试去兼顾各个测试数据点

-

解决办法:

- 1)重新清洗数据,导致过拟合的一个原因也有可能是数据不纯导致的,如果出现了过拟合就需要我们重新清洗数据。

- 2)增大数据的训练量,还有一个原因就是我们用于训练的数据量太小导致的,训练数据占总数据的比例过小。

- 3)正则化

- 4)减少特征维度,防止维灾难

-

3 正则化

3.1 什么是正则化

在解决回归过拟合中,我们选择正则化。但是对于其他机器学习算法如分类算法来说也会出现这样的问题,除了一些算法本身作用之外(决策树、神经网络),我们更多的也是去自己做特征选择,包括之前说的删除、合并一些特征

如何解决?

在学习的时候,数据提供的特征有些影响模型复杂度或者这个特征的数据点异常较多,所以算法在学习的时候尽量减少这个特征的影响(甚至删除某个特征的影响),这就是正则化

注:调整时候,算法并不知道某个特征影响,而是去调整参数得出优化的结果

3.2 正则化类别

-

L2正则化

- 作用:可以使得其中一些W的都很小,都接近于0,削弱某个特征的影响

- 优点:越小的参数说明模型越简单,越简单的模型则越不容易产生过拟合现象

- Ridge回归

-

L1正则化

- 作用:可以使得其中一些W的值直接为0,删除这个特征的影响

- LASSO回归

-

拓展阅读:

4 小结

-

欠拟合【掌握】

-

在训练集上表现不好,在测试集上表现不好

-

解决方法:

-

继续学习

- 1.添加其他特征项

- 2.添加多项式特征

-

-

-

过拟合【掌握】

-

在训练集上表现好,在测试集上表现不好

-

解决方法:

- 1.重新清洗数据集

- 2.增大数据的训练量

- 3.正则化

- 4.减少特征维度

-

-

正则化【掌握】

-

通过限制高次项的系数进行防止过拟合

-

L1正则化

- 理解:直接把高次项前面的系数变为0

- Lasso回归

-

L2正则化

- 理解:把高次项前面的系数变成特别小的值

- 岭回归

-